In diesem Tutorial befassen wir uns mit der Migration von Servern auf VMware zu OpenStack. Nach der kürzlichen Übernahme VMwares durch Broadcom haben in den vergangenen Wochen viele kleinere Cloud Service Provider (CSPs) Mitteilung zur Kündigung ihrer Mitgliedschaft in VMWare’s Partnerprogramm erhalten. Viele Endkunden befinden sich dementsprechend in einer ungewissen Situation, die durch die schlechte Informationslage noch akuter wird.

Die ersten Anbieter kompatibler Software erwägen bereits die Möglichkeit, alternative Plattformen zu unterstützen. Eine dieser möglichen Alternativen könnte OpenStack sein, die weltweit meistgenutzte Open Source Cloud Software. Auch die Virtual Private Clouds (VPCs) bei NWS bauen auf OpenStack auf.

Möchtest du lieber mehr über OpenStack bei NWS erfahren und wissen, warum es eine sinnvolle Alternative zu VMwares proprietären Produkten sein kann, bist du auf unserer Infoseite richtig!

Voraussetzungen

Für die Anwendung der in diesem Tutorial beschriebenen Migrationsschritte benötigen wir zum einen einen Linuxserver, der als „Migrationsserver“ dienen wird, zum Anderen Hilfssoftware. Sämtliche Software ist Open Source, frei beziehbar, und kann aus den offiziellen Paketquellen aller gängigen Betriebssysteme installiert werden.

Der Migrationsserver

Der Linuxserver wird hauptsächlich dazu benötigt, das von VMware als .vmdk exportierte VM-Image in ein OpenStack-kompatibles raw Image zu konvertieren. Da wir das konvertierte Image im Anschluss in OpenStack hochladen müssen, empfiehlt es sich, unseren Migrationsserver aus Netzwerksicht möglichst nah an unserem OpenStack aufzusetzen.

Was das Betriebssystem angeht, gibt es keine falsche Wahl – die benötigte Software ist in den offiziellen Paketquellen aller gängigen Betriebssysteme verfügbar. Ich habe mich für dieses Tutorial für Ubuntu 22.04.3 LTS (Jammy Jellyfish) entschieden.

Die Hilfssoftware

Auf unserem Migrationsserver installieren wir nach Einrichtung die folgende Software:

- die

openstackCLI - die

qemu-imgCLI

Unter Ubuntu können diese Abhängigkeiten durch folgende Softwarepakete installiert werden:

apt install qemu-utils python3-openstackclient

Nach der erfolgreichen Installation können wir die installierten Tools testen:

openstack --version openstack 5.8.0 qemu-img --version qemu-img version 6.2.0 (Debian 1:6.2+dfsg-2ubuntu6.16) © (c) 2003-2021 Fabrice Bellard and the QEMU Project developers

Vorbereiten des Images

Der nächste Schritt beinhaltet den Export unser virtuellen Maschine tutorial-host aus VMware. Hierfür benötigen wir Zugriff auf das hostende vCenter:

- Navigiere zum Host in der vCenter UI

- Identifiziere den Datastore, der die Daten des Hosts hält

- Navigiere zum identifizierten Datastore und öffne den Datastore Browser

- Finde den Ordner, der nach dem Host benannt ist

- Downloade die

.vmdk-Datei über den entsprechenden Dialog

Tatsächlich sollten nun zwei Dateien gedownloaded werden, eine kleine Datei namens tutorial-host.vmdk, und eine große Datei namens tutorial-host-flat.vmdk.

Nach erfolgreichem Download müssen beide Dateien auf unseren Migrationsserver übertragen werden, bevor wir mit der Konvertierung starten können: Wir möchten unsere .vmdk-Dateien in ein einziges raw Image konvertieren, was mittels folgendem Befehl funktioniert:

qemu-img convert -p -f vmdk -O raw tutorial-host.vmdk tutorial-host.raw

Die Konvertierung sollte nun stattfinden, während uns die CLI mit einer Fortschrittsanzeige auf dem Laufenden hält. Nach ein paar Minuten – je nach Größe der .vmdk-Dateien – sollte eine neue Datei tutorial-host.raw im Arbeitsverzeichnis zu sehen sein.

Vorbereiten der OpenStackumgebung

Bevor wir die Migration unseres Servers von VMware zu OpenStack fortsetzen können, sind noch einige Vorbereitungen zu treffen, teils zwingend notwendige (Upload des konvertierten Images), und teils optionale (Setzen von IP und/oder MAC-Adressen).

Fangen wir doch mit dem Upload des Images an.

Upload des Images nach OpenStack

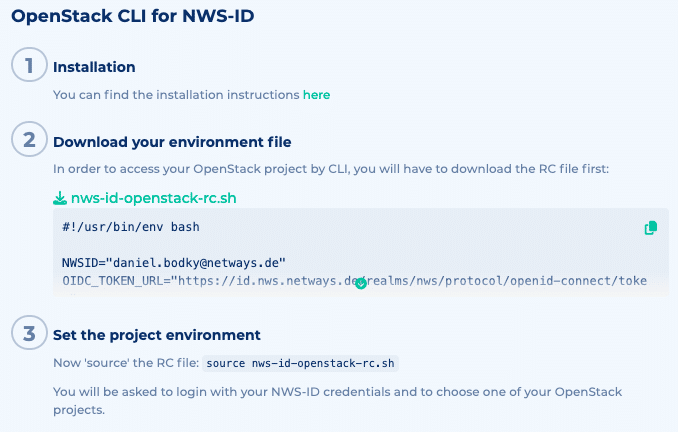

Da wir ab hier direkt mit OpenStack kommunizieren (wollen), müssen wir zuerst unsere openstack CLI konfigurieren. Konkret müssen wir Authentifizierung und Projekt definieren. Die benötigten Informationen können aus Horizon (OpenStack’s Weboberfläche) heruntergeladen werden – detaillierte Instruktionen hierfür finden sich in der offiziellen Dokumentation.

Folgst du dem Tutorial auf einem bei NWS betriebenem OpenStack, kannst du die benötigten Informationen auf deiner OpenStack Übersichtsseite auf my.nws.netways.de herunterladen. Auf diese Weise kannst du dich u.A. mit deiner NWS-ID in der OpenStack CLI authentifizieren.

You can find instructions to configure the openstack CLI with your NWS ID on your OpenStack’s overview page.

Haben wir unseren OpenStackRC-Datei heruntergeladen, können wir sie einlesen und im Anschluss das konvertierte Image nach Glance (OpenStack’s Imagespeicher) hochladen:

source <OpenstackRC.sh>; openstack image create --disk-format raw \ --file tutorial-host.raw --progress tutorial-host-image

Wie qemu-img zeigt uns auch openstack den Fortschritt der Aktion an. Ist das Image erfolgreich hochgeladen, könnten wir bereits unsere virtuelle Maschine auf OpenStack starten!

Konfigurieren von Netzwerkeinstellungen

Eine weitere, optionale Vorbereitung, die ich bereits zu Beginn dieses Abschnittes erwähnt hatte, ist das Einrichten eines sog. Ports in OpenStack. Mithilfe dieses Ports können wir spezifische IP- bzw. MAC-Adressen an unsere virtuelle Maschine hängen, um neben dem gesicherten Zustand der Maschine auch die ursprünglichen Netzwerkeinstellungen zu migrieren.

Um einen solchen Port zu konfigurieren, benötigen wir ein paar Informationen aus OpenStack:

- die ID des Netzwerks, in dem der Port erstellt werden soll; Wir können alle verfügbaren Netzwerke wie folgt auflisten:

openstack network list - die ID eines Subnetzes innerhalb des gewählten Netzwerks; erneut können wir alle Optionen auflisten:

openstack subnet list - [optional] die ID(s) der Security Groups, die wir mit dem Port und somit auch unserer VM verknüpfen wollen:

openstack security group list

Haben wir alle benötigten Informationen beisammen, können wir den Port erstellen – die gewählten IDs bzw. IP-/MAC-Adressen müssen an den entsprechenden Stellen eingetragen werden:

penstack port create --fixed-ip "subnet=<subnet-id>,ip-address=<ip-address>" \

--security-group <securitygroup-id> \

--network <network-id> \

--mac-address <mac-address> \

tutorial-host-port

Möchten wir mehrere Security Groups mit unserer VM verknüpfen, können wir den Parameter --security-group einfach wiederholen und die entsprechenden IDs eintragen. Analog können wir den Parameter auch weglassen, möchten wir vorerst keine Verknüpfungen vornehmen.

Wenn wir im weiteren Verlauf des Tutorials unsere VM in OpenStack erstellen und den soeben konfigurierten Port nutzen möchten, können wir diesen mit folgendem Parameter referenzieren: --port tutorial-host-port

Starten der Virtuellen Maschine

Nun haben wir alle notwendigen und optionalen Voraussetzungen erfüllt, um unsere virtuelle Maschine in OpenStack starten zu können – doch auch hierbei gibt es wieder verschiedene Optionen hinsichtlich Ausfallsicherheit und Datenpersistenz.

Aus diesem Grund schauen wir uns zum Abschluss des Tutorials zwei verschiedene Möglichkeiten an, unsere VM in OpenStack zu starten.

Starten der Virtuellen Maschine von einem Image

Die einfachste Möglichkeit, die Migration unseres Servers auf VMware zu OpenStack abzuschließen, ist das Booten direkt von unserem hochgeladenen Image. Unsere VM ist lediglich einen Befehl entfernt:

openstack server create --image tutorial-host-image --flavor s1.small \

--wait tutorial-host

Nach ein paar Augenblicken sollte uns die openstack CLI die Informationen der neu erstellten VM augeben. Wir können den Status der Maschine in Horizon überprüfen:

Hierzu navigieren wir über Compute > Instances zur Übersicht aller Server im jeweiligen Projekt und sollten nun eine VM namens tutorial-host im Power State Running sehen.

Das war einfach! Diese Einfachheit hat allerdings auch ihre Nachteile: Da wir unsere VM direkt vom importierten Image booten, sind sämtliche Daten der VM lediglich auf ihrem Hypervisor hinterlegt.

Haben wir also eine Datenpersistenz über Restarts der VM hinweg, sieht es im Falle eines Ausfalles des Hypervisor schlecht aus: Wir können die Daten der VM nicht auf einen anderen Hypervisor umziehen. Auch nach Löschen der VM selbst sind die gespeicherten Daten verloren.

Wenn dein Anwendungsfall von diesen Einschränkungen nicht betroffen ist, ist das klasse – falls du allerdings eine robustere Lösung benötigst, lies weiter und erfahre, wie wir unsere VMs von persistenten Volumes starten können.

Starten der Virtuellen Maschine von einem Volume

Anstatt unsere Virtuelle Maschine wie im letzten Abschnitt direkt von einem Image zu starten und somit komplett abhängig vom Hypervisor zu sein, können wir stattdessen von einem Volume booten. Daraus ergeben sich ein paar Vorteile:

- bei Ausfall eines Hypervisors können wir die VM auf einen anderen Hypervisor umziehen – die persistenten Daten sind auch von dort zugreifbar

- nach Löschen einer VM können wir das Volume für späteren Gebrauch behalten

Der entsprechende Befehl auf der openstack CLI lautet wie folgt:

openstack server create --image tutorial-host-image --flavor s1.small \

--boot-from-volume 8 --wait tutorial-host

Man beachte den neuen Parameter --boot-from-volume 8 im Vergleich zu obigem Beispiel. Durch ihn teilen wir OpenStack mit, dass es ein neues Volume (8GB) auf Basis unseres referenzierten Images erstellen soll, das als Root Disk unserer VM dient.

Durch diese Maßnahme booten wir von einem dedizierten Volume, das die Daten auf der VM ordentlich persistiert.

Analog zu obigem Beispiel können wir den Zustand unserer VM unter Compute > Instances in Horizon überprüfen – es sollte alles in Ordnung sein.

Wie geht es weiter?

Auch wenn wir uns jetzt mit verschiedenen grundsätzlichen Migrationsszenarien inkl. Netzwerk- und Speichereinstellungen von Servern auf VMware zu OpenStack befasst haben, gibt es natürlich noch so einige andere Dinge zu beachten:

Wie verhält es sich bspw. mit Windows VMs? Was ist mit zusätzlich gemounteten Disks? Und wie verhält es sich mit zusätzlichen Scripten, SSH-Schlüsseln und anderen Dateien, die evtl. auf den VMs landen sollten?

Fragen wie diese wollen wir in zukünftigen Tutorials behandeln, also schaue doch mal wieder vorbei oder abonniere direkt unseren Newsletter, um stets auf dem Laufenden zu sein. Solltest Du Fragen zu OpenStack, unserem NWS-Portfolio oder dem Tutorial selbst haben, schicke uns gerne eine Nachricht.