Mit unserer neuen OpenStack-Umgebung feiern wir Erfolge – Performance, Stabilität, Flexibilität und günstige Preise überzeugen unsere Kunden. Die Vielzahl von Funktionen überfordert aber den ein oder anderen Anwender bei der ersten Nutzung. Wir helfen aber auch hier sehr gern Licht ins Dunkel zu bringen und zeigen auf, wie einfach es eigentlich ist.

Zu Beginn benötigen wir einen NWS-Account. Dieser lässt sich kostenfrei unter https://nws.netways.de anlegen. Hier gibt man lediglich eine Mailadresse und das gewünschte Passwort an, sowie ob es sich um ein Business oder Standard-Konto handelt. Kurze Zeit später kommt ein E-Mail-Validierungslink per Mail. Nach der Bestätigung des Kontos kann man sich bereits einloggen. Für den Quick-Start ist eine Demo-Kreditkarte hinterlegt, es empfiehlt sich hier aber über die Accountkachel->“Zahlungsmethode bearbeiten“ die gewünschte Zahlungsweise (Kreditkarte/Rechnung/PayPal) zu hinterlegen.

Ebenfalls über die Accountkachel ->“Konto bearbeiten“ können wir nun unsere gewünschten Rechnungsdaten, Mailadresse für den Rechnungsversand etc. angeben und validieren unser Konto via Anruf oder SMS.

Final bringt uns der Klick auf „App starten“ zum Ziel – hier folgt man nur noch dem OpenStack-Button und bestätigt die ungeliebten Klauseln zu AGB und Datenschutz – aber was sein muss, muss sein.

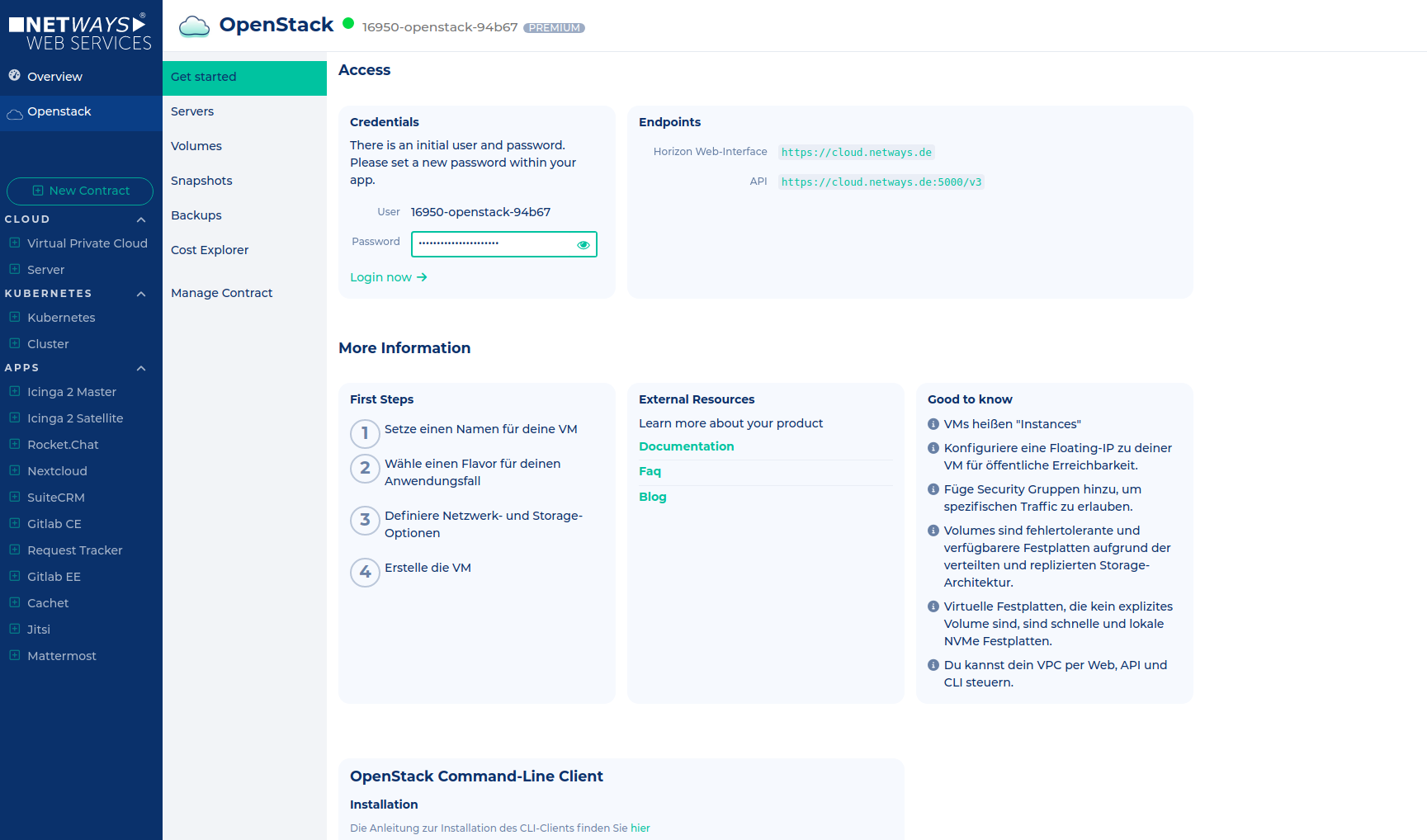

Nun taucht in unserer App-Übersicht unser OpenStack auf. Nur einen Klick entfernt warten hinter der unscheinbaren Kachel schon alle wichtigen Informationen zum Start.

Seit wir ein neues NWS-Frontend haben, könnte man den „Servers“-Knopf benutzen, um eine VM sehr einfach in nur einem Schritt zu erstellen. Da es bei diesem Artikel jedoch um OpenStack geht, machen wir so weiter.

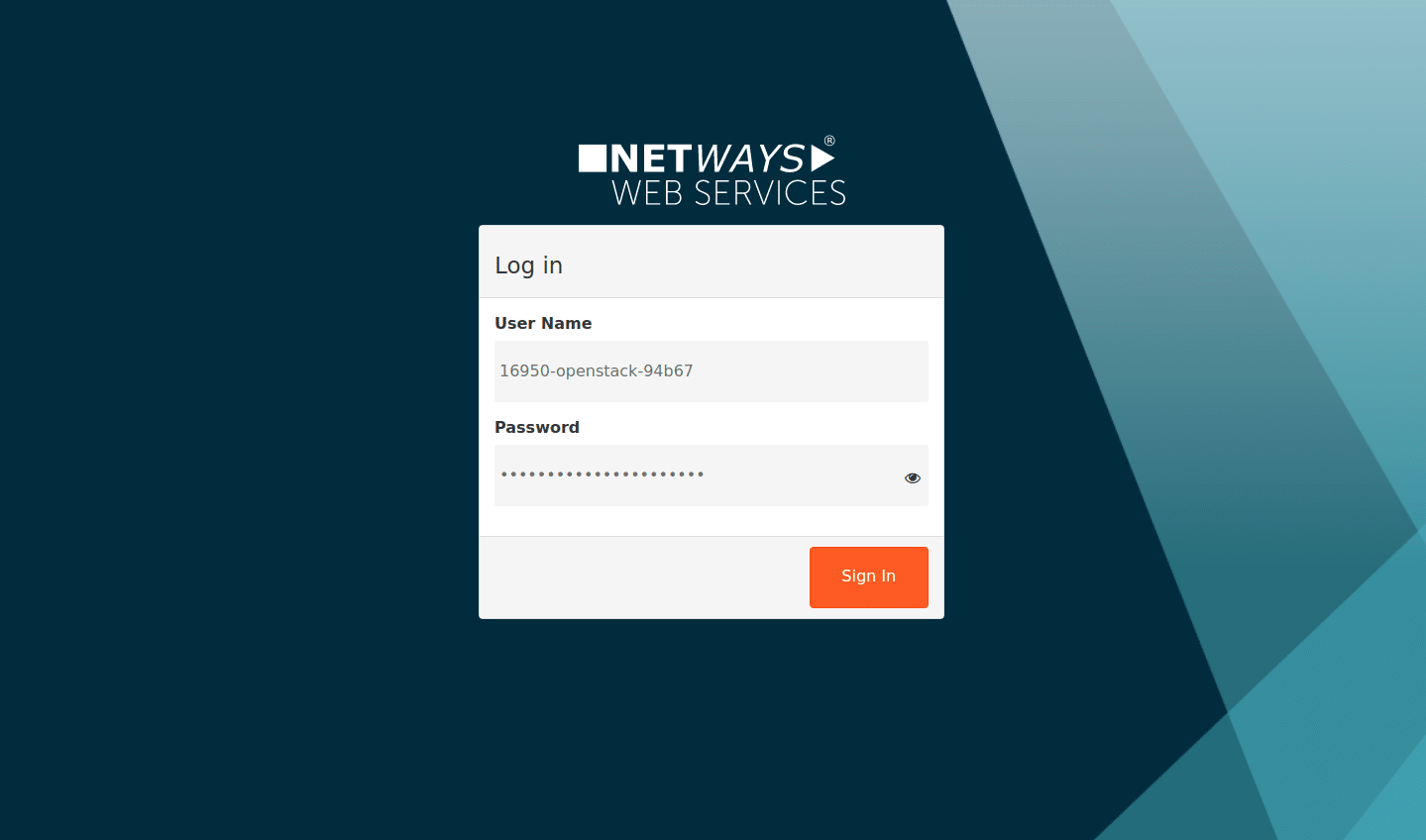

Nach einem Klick auf den Link zum Web-Interface erscheint das OpenStack-Anmeldefenster. Die Anmeldedaten hier unterscheiden sich von denen, die Zugang zum NWS gewähren, sind aber ebenfalls in den App-Details OpenStack zu entnehmen.

Also fügen wir die erspähten Daten nun ein.

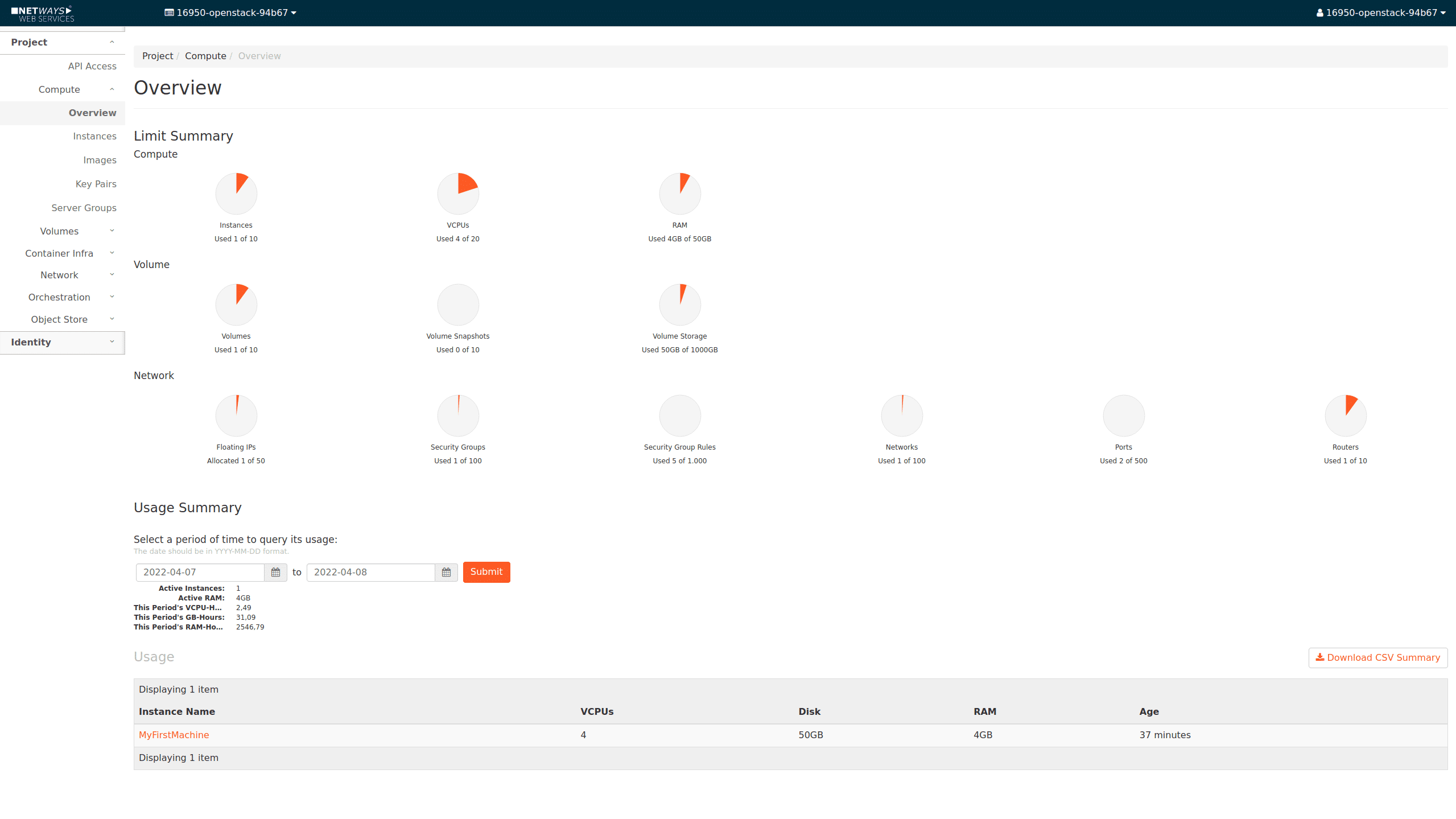

Das wärs dann auch schon – unser OpenStack ist betriebsbereit und wartet darauf, dass der erste Server angelegt wird.

Die erste Maschine starten

Keine Sorge – auch das geht fast genauso einfach.

Navigieren wir zu „Compute“->“Instances“ und starten im oberen rechten Eck eine neue Instanz.

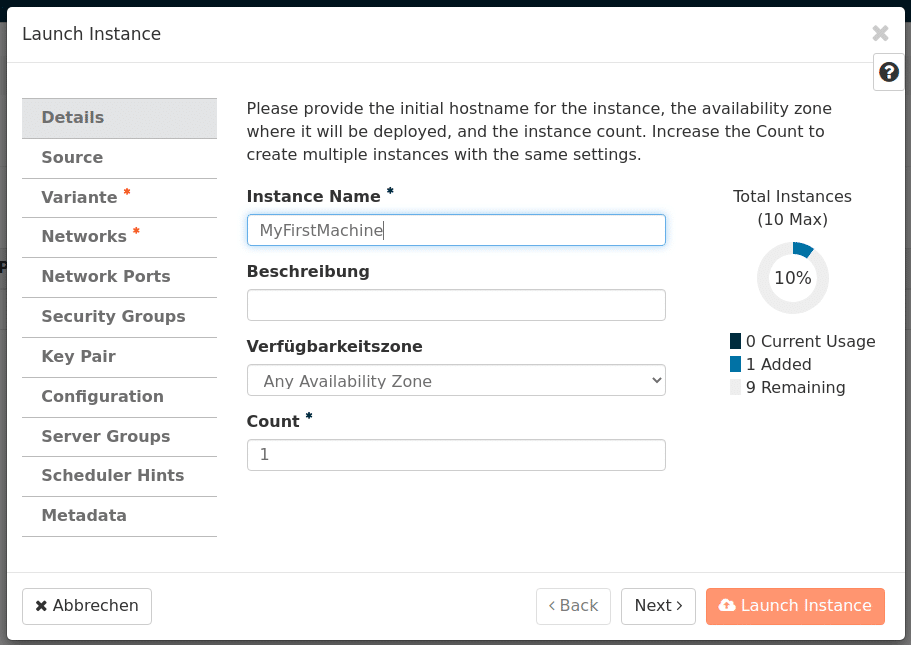

Im ersten Schritt vergeben wir einen Namen für unsere Instanz.

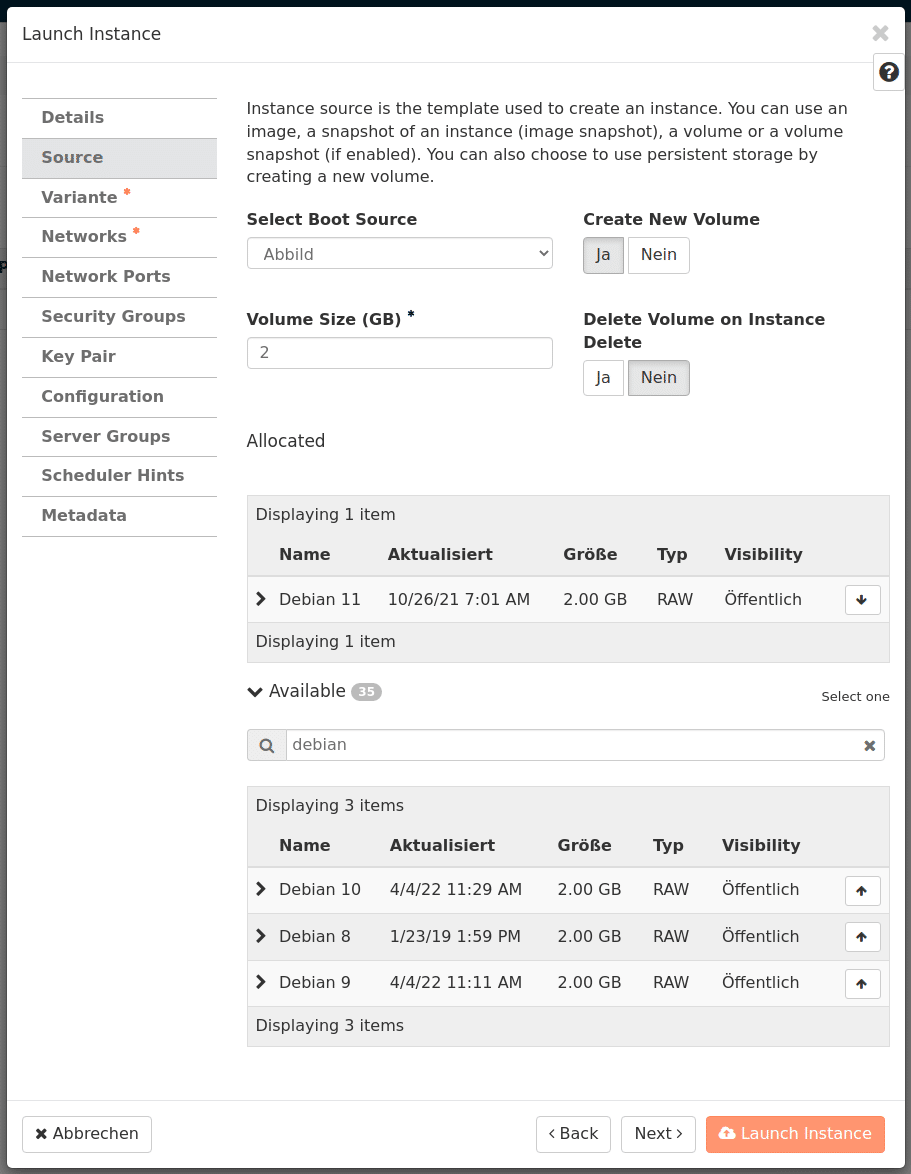

Nun arbeiten wir die weiteren Register auf der linken Seite durch und besuchen den Punkt „Source“.

Hier wählen wir als Boot-Source „Image“ aus und suchen uns unten aus der Liste das gewünschte Betriebssystem aus (ganz rechts der Pfeil zum Auswählen). Dann bliebe hier noch die Frage: „Create New Volume“?

Klickt man hier „Yes“ bekommt man eine VM mit Ceph-Netzwerk-Storage-System-Volume.

Dieses wird dreifach über zwei Standorte repliziert. Stirbt der Hypervisor, starten wir die betroffenen VMs auf anderen Hosts erneut an.

„No“ würde dazu führen, dass die zu erstellende VM ihre Systemdaten direkt auf einer SSD auf dem Hypervisor hat.

Dies ist zwar schneller, hat jedoch den Nachteil, dass die Daten komplett auf nur einem physischen Host (RAID 1) liegen. Des Weiteren lassen sich diese VMs – sollte der Hypervisor in die Knie gehen – erst wieder starten, wenn dieser gefixt ist.

Windows-Server-Liebhaber mögen aus Performanz-Gründen diese Option wählen.

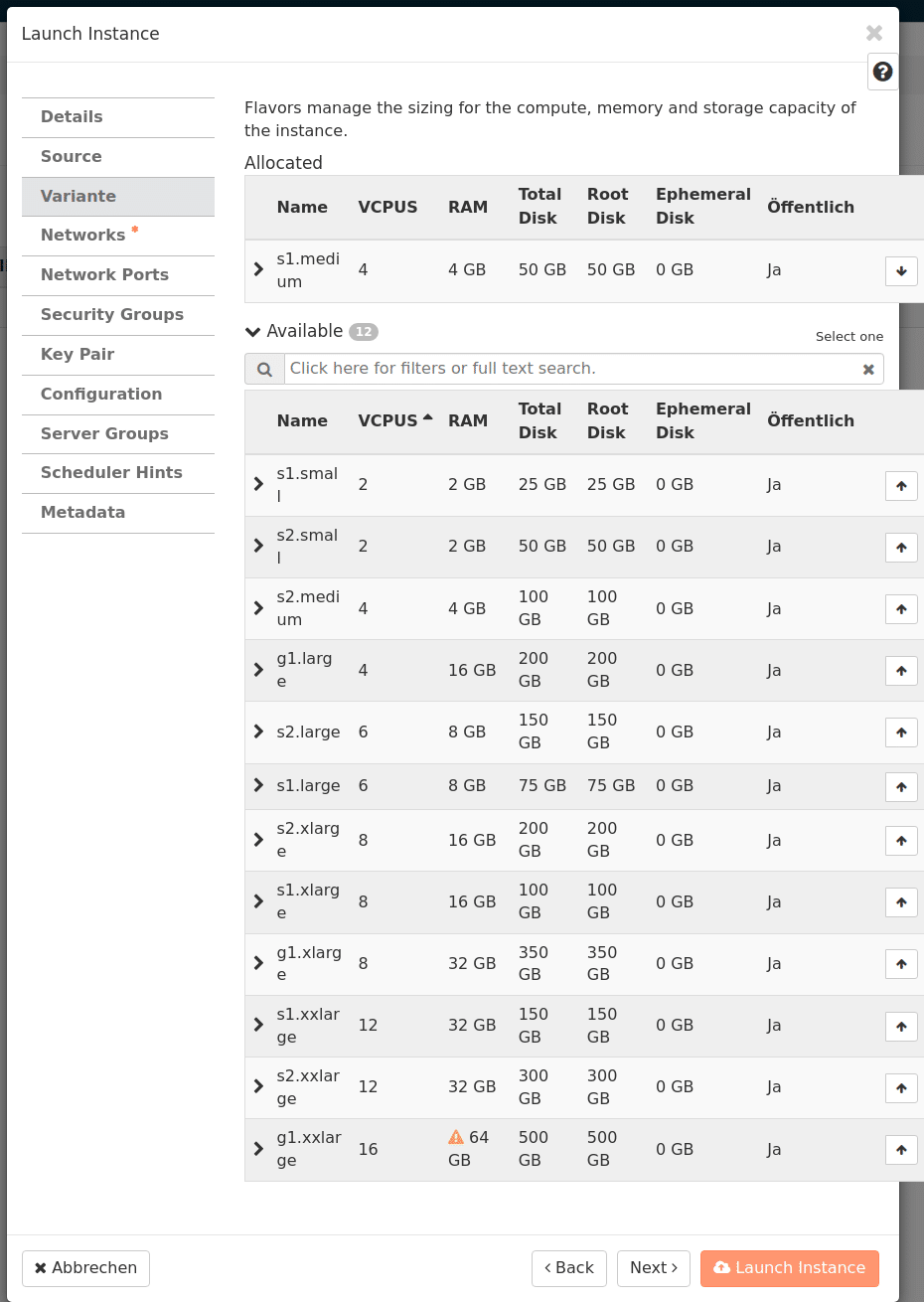

Der Menüpunkt Flavor bietet verschiedene Presets für die gewünschten Größen der Maschinen. Hier wählt man aus, was man benötigt. Fehlt ein gewünschtes Flavor? Einfach eine kurze Mail schreiben und wir kümmern uns drum!

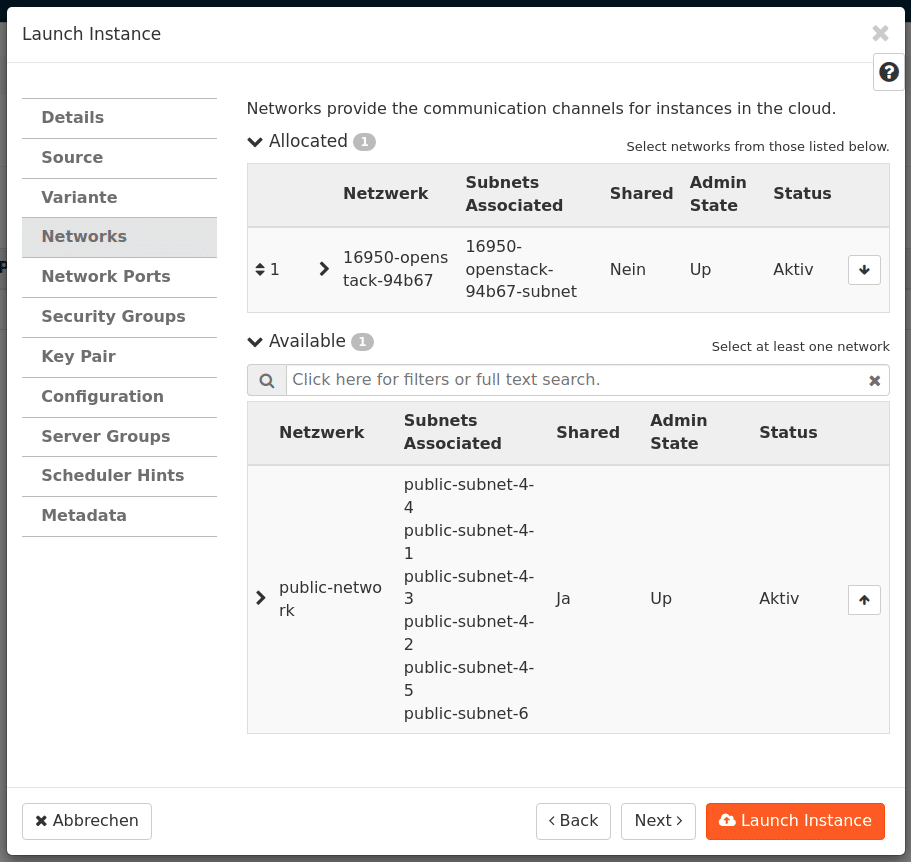

Im nächsten Register dreht sich alles um Netzwerk, dort wird unser OpenStack-Netzwerk ausgewählt, was gleichlautend mit unserem OpenStack-Projekt ist.

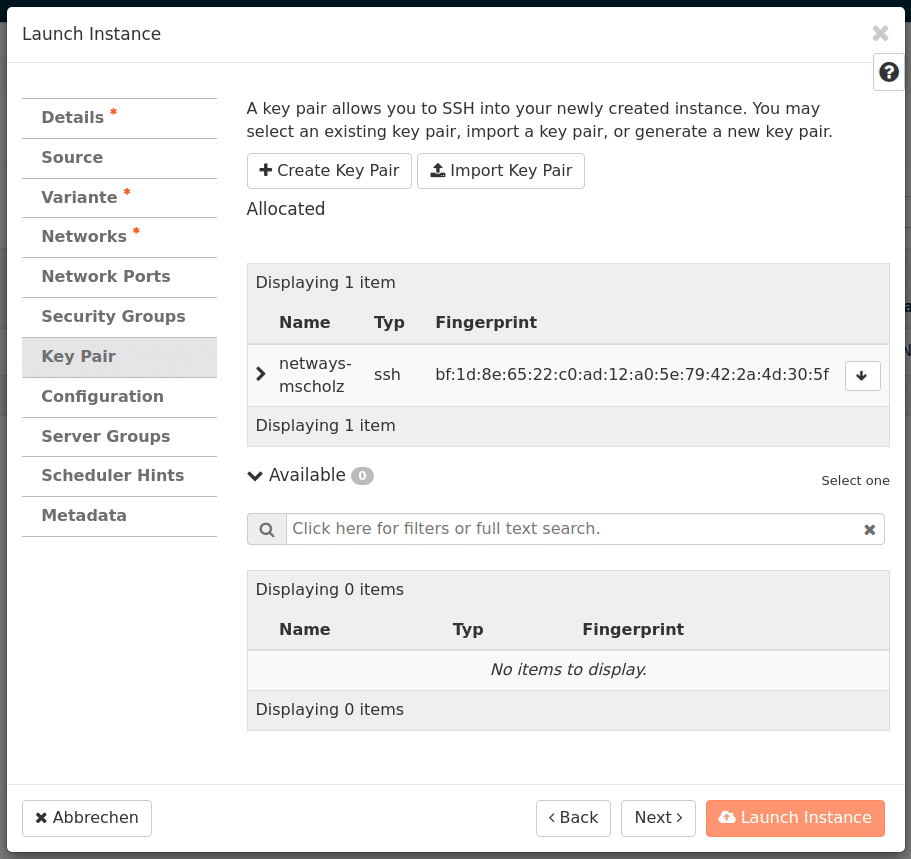

Für den Moment ignorieren wir vorerst ein paar Menüpunkte und widmen unsere Aufmerksamkeit dem Menüpunkt Key-Pair.

Über den Button „Import Key Pair“ importieren wir unseren SSH-Pubkey in seiner ungekürzten Schönheit und vergeben einen beliebigen Namen. Auch dieser wird wieder „nach oben“ reingeklickt.

Final kann die Instanz gestartet werden – schon wenige Sekunden später steht diese bereit.

Für die erste Nutzung müssen jedoch noch 2 Dinge erledigt werden.

Floating-IP zuweisen

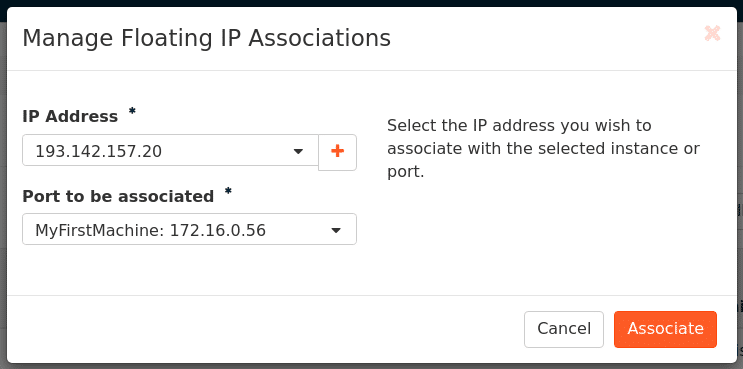

Hierzu klicken wir in der Maschinenübersicht rechts bei der gewünschten Maschine auf den kleinen Pfeil nach unten auf „Associate Floating IP“, beziehen mittels „+“ eine Neue IP aus dem Pool und weisen Sie der Maschine zu.

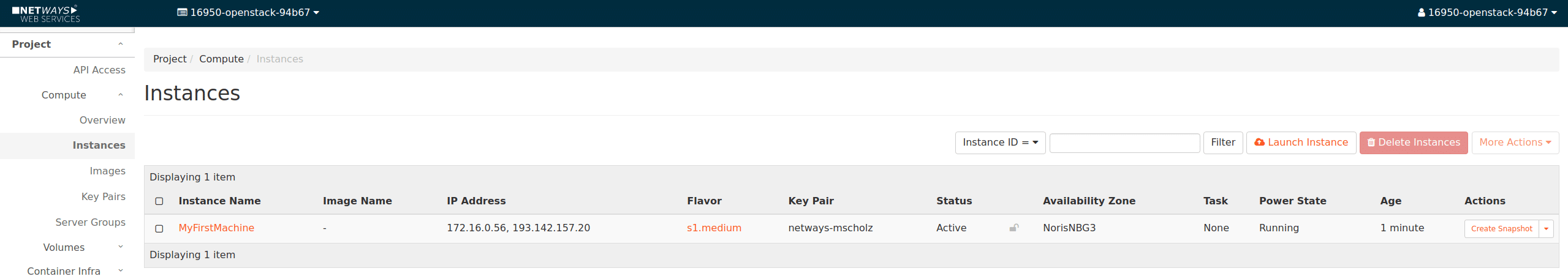

Nun sehen wir, dass die Maschine eine IP im internen Netz hat, sowie die gerade zugewiesene Floating-IP – diese brauchen wir später, um uns auf die Maschine zu verbinden.

Security-Groups bearbeiten

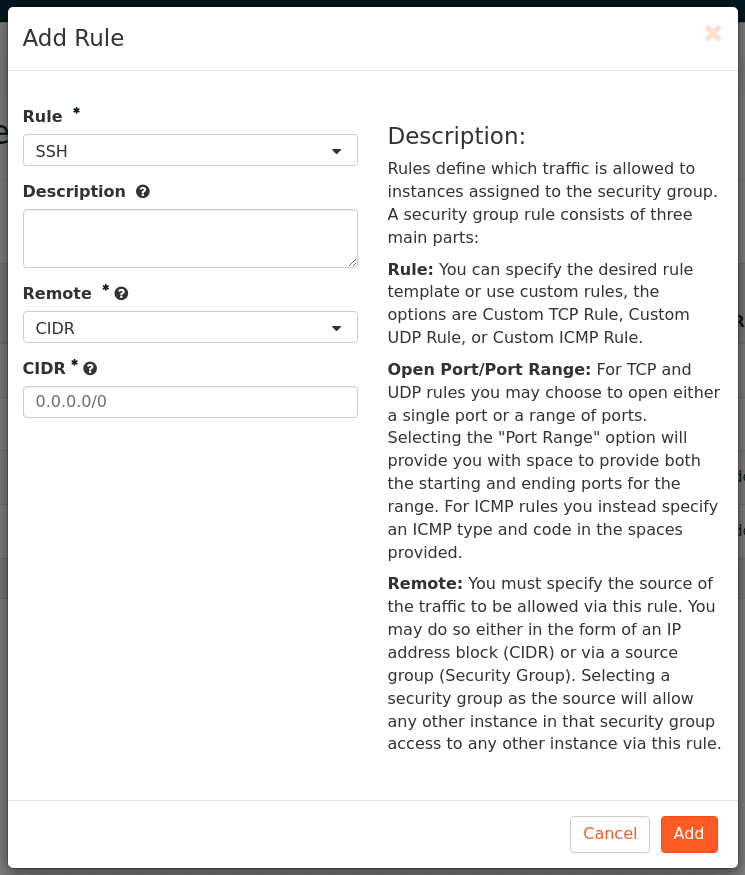

Unser OpenStack bring bereits eine Firewall mit. Deshalb funktioniert der Zugang via SSH oder RDP noch nicht. Dies ist jedoch mit wenigen Klicks ebenfalls erledigt.

In der Hauptnavigation von OpenStack besuchen wir Network->Security Groups. Hier „managen“ wir die „Rules“ unserer default Security-Group via „Manage Rules“ und fügen mittels „Add Rule“ eine neue Regel für SSH hinzu und geben vorerst alle Netze für den Zugriff frei.

Da alle angelegten Maschinen die „default“ Regel bereits enthalten, funktioniert ab jetzt der Zugriff auf die Maschine via SSH. In späteren Artikeln gehen wir näher auf die Handhabung mit Security-Groups und Zuweisung dieser zu Maschinen ein, aber das würde in diesem Artikel jetzt den Rahmen sprengen.

In diesem Artikel gehen wir genauer auf die Sicherheitsgruppen ein.

Mit Maschine verbinden

Wenn alle Schritte wie beschrieben durchgeführt wurden, kann man sich jetzt via SSH mit der Maschine via Floating-IP verbinden. Für Ubuntu-Systeme verbindet man sich als User ubuntu, bei Debian als debian usw. Bei Windows-Maschinen kann man das Passwort beim ersten Starten eingeben, hierzu muss man sich etwas durch die Details in der Instance-Übersicht der Maschine klicken.

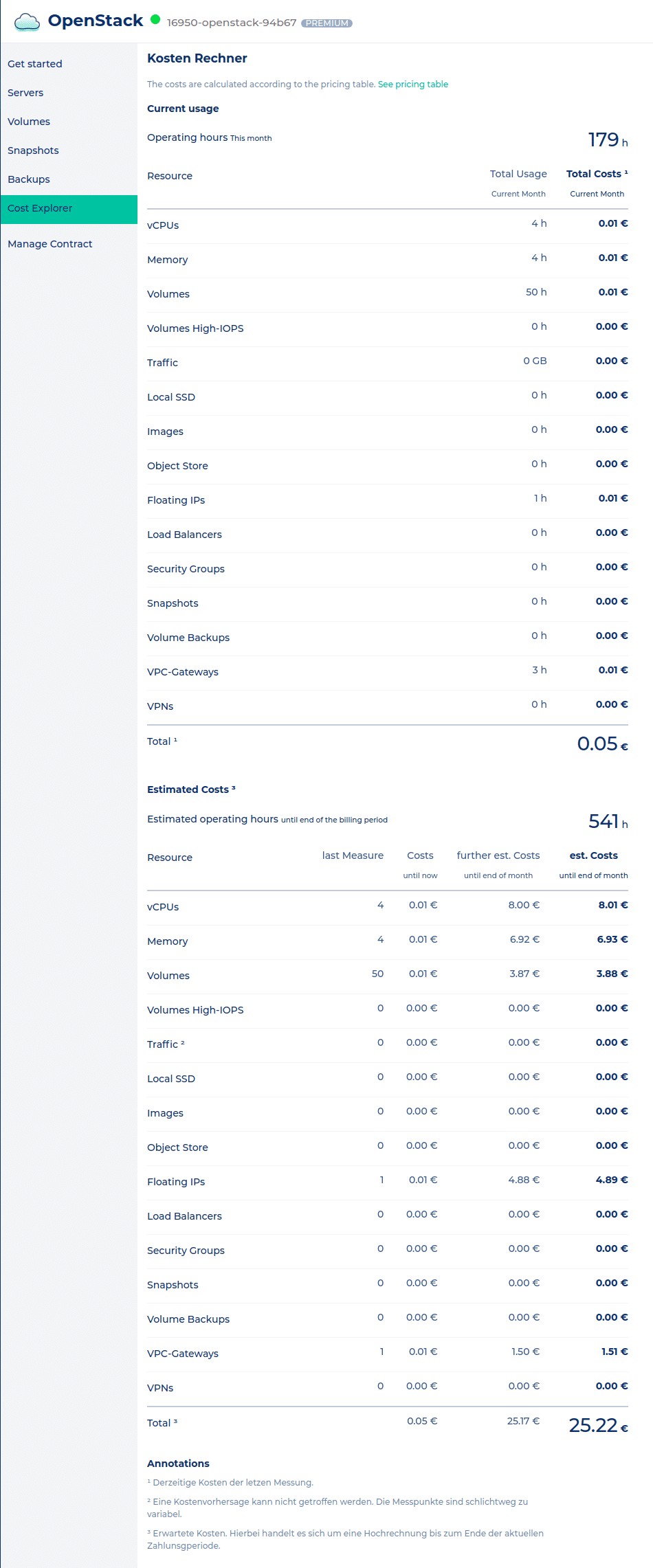

Kosten

Zeit ist Geld – auch bei uns! Deshalb werden alle Maschinen bzw. die einzeln genutzten Ressourcen stundengenau abgerechnet (Preise hier) und zwar zu fairen und transparenten Preisen. Damit man alles im Auge behält, haben wir die aktuell aufgelaufenen Kosten und den Forecast für den laufenden Monat (bei gleichbleibender Nutzung) in unserem Kosten Rechner festgehalten.

Need more?

Kein Problem. Mit etwas Geduld kommen hier mehr und mehr Artikel. Wer nicht warten kann oder sich nicht kümmern will, kann bei uns eine Remote-Schulung buchen, unser Webinar ansehen oder unsere kompetenten MyEngineers buchen.